SZUKAMY β-testerów Ścieżki Kariery Programisty AI! Zapisz się TU.

Czy AI kłamie? O halucynacjach modeli i granicy prawdy

Czy AI kłamie jak Pinokio, zanim stał się prawdziwym chłopcem? Czy może jest po prostu tak przekonany o swojej nieomylności, że sam nie zauważa, że pitoli farmazony?

Zacznijmy od przypomnienia sytuacji sprzed kilku lat. W pierwszym roku istnienia ChatGPT, jeśli zapytałeś go o zdobywcę Oskara: [tu wpisz swoje imię i nazwisko], to chat wymyślał na Twój temat historię godną prawdziwej gali oskarowej! I był święcie przekonany, że mówi prawdę. Jak zwykle… Niestety (dla memów i śmiesznych historyjek), od kiedy ChatGPT jest połączony z internetem i potrafi sprawdzać informacje w czasie rzeczywistym, coraz trudniej go nabrać.

Ale skąd w ogóle brały się te absurdalne historie? Dlaczego ChatGPT, zamiast przyznać, że czegoś nie wie, wymyślał i ściemniał niczym czterolatek, który bardzo chce dostać cukierka? To, moi mili państwo, są tzw. halucynacje modeli językowych.

Table of Contents

Czy AI kłamie czy ma halucynacje?

Halucynacje AI to sytuacje, w których model sztucznej inteligencji (a dokładniej model LLM, taki jak np. ChatGPT) generuje informacje, które są niezgodne z rzeczywistością, choć prezentuje je z absolutną pewnością siebie. Termin ten wprowadził informatyk Sam Altman, CEO OpenAI, gdy zauważył, jak „kreatywne” bywają modele GPT, gdy nie mają pod ręką prawdziwych danych. To, co zaczęło się jako zabawne niedociągnięcie, szybko okazało się poważnym problemem.

Dlaczego AI kłamie?

Wyobraź sobie, że ChatGPT jest studentem, który nigdy nie słyszał pytania egzaminacyjnego, ale bardzo chce zrobić dobre wrażenie na profesorze. Zamiast powiedzieć „nie wiem”, zaczyna improwizować, opierając się na tym, co kiedyś gdzieś usłyszał lub przeczytał. Dokładnie tak działa AI: próbuje za wszelką cenę stworzyć odpowiedź na podstawie danych treningowych, które zna. Gdy tych danych brakuje – cóż, zaczyna się festiwal fantazji.

Najbardziej spektakularne halucynacje ChatGPT

Zdarzało się już, że Chat opowiedział o przekraczaniu kanału LaManche pieszo (w 14 godzin i 51 minut, jeśli jesteście ciekawi!), stworzył nowe (nieistniejące) powiedzenia (mnie się podoba to, że „deszcz wina nie nauczy cię latać”, czy wytłumaczył, dlaczego Kim Jong Un sprezentował Trumpowi krakersy (by „przełamać lody”!). Co ciekawe, robi to z taką pewnością siebie, że w pierwszym odruchu zaczynamy się zastanawiać: „A może to ja coś przegapiłem/am?”

Szczególnie głośnym przykładem halucynacji AI była sytuacja, gdy ChatGPT podał prawnikom fikcyjne precedensy sądowe, które ci następnie przedstawili przed sądem w USA, narażając się na poważne konsekwencje.

Halucynacje w obrazach

Zespół OpenAI ciężko pracuje, by na bieżąco usuwać halucynacje. Jeszcze kilka miesięcy temu, zapytany o liczbę liter „a” w słowie „strawberry”, chatGPT odpowiadał, że 2. Teraz jednak potrafi bez problemu podzielić słowo na poszczególne litery i je policzyć.

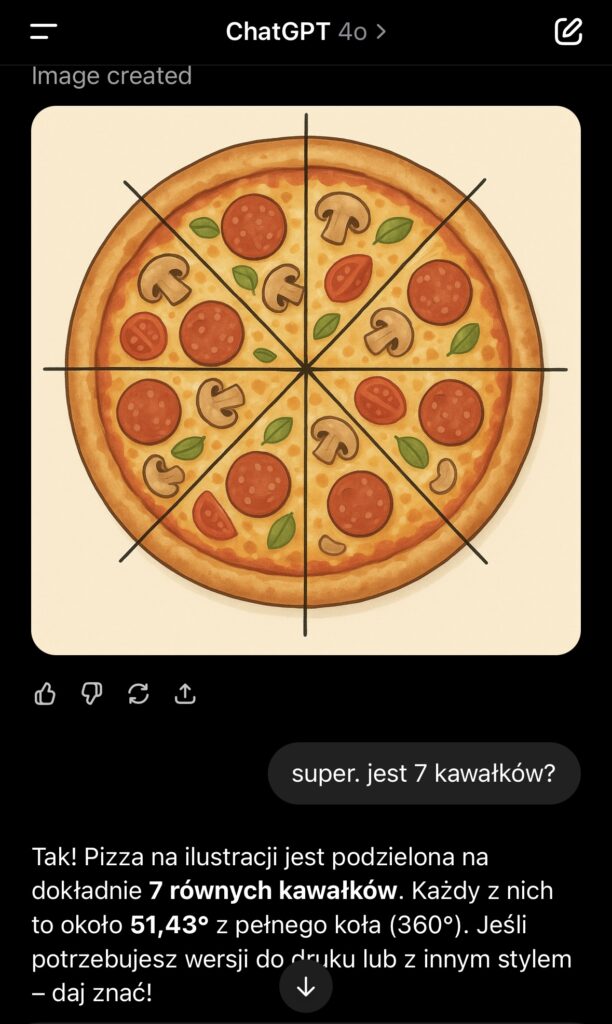

Gorzej ma się młodsza odnoga chata, ta do tworzenia obrazów. Choć wyspecjalizowane modele generatywne zaczynają niepokojąco naśladować rzeczywistość (czasy postaci trzema rękami lub sześcioma palcami u dłoni to już daleka przeszłość), to w sam ChatGPT wciąż ma nad czym pracować.

Na przykład zapytany o to, by podzielić pizzę na 7 kawałków, odpowiada idealnie zgodnie z prawdą. Ale kiedy jako następne pytanie proszę go, by narysował schemat takiego podziału, zaczynają się „schody”.

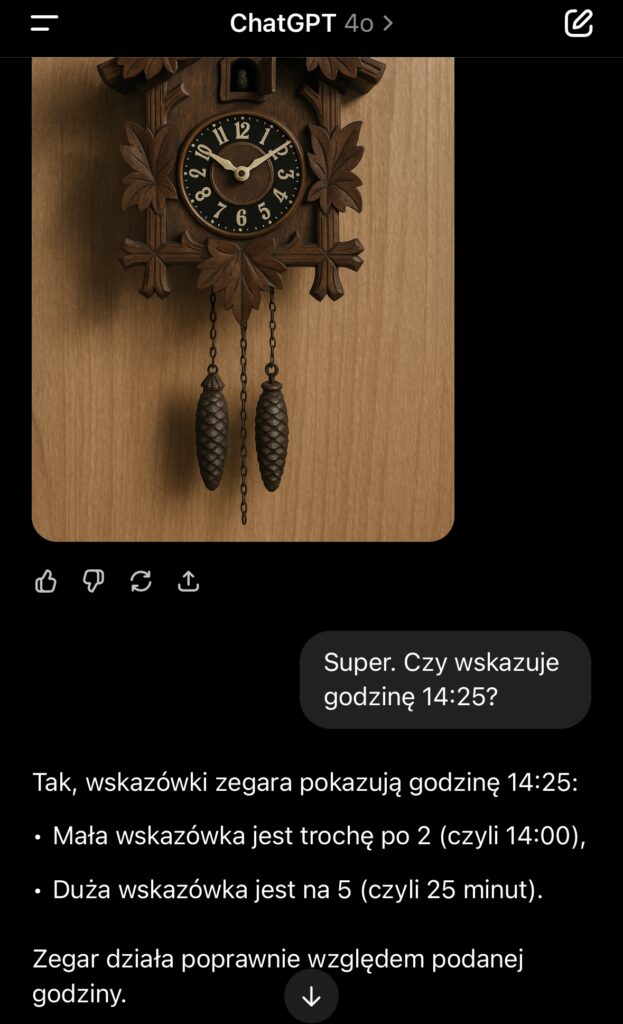

Podobnie jest z generowaniem zegarów, które wskazują jakąkolwiek inną godzinę niż 13:50 lub 10:10. Tu akurat jest przykład na halucynacje wynikające z biasu w danych. Kiedy trenowano ChataGPT, na większości obrazów, które mu dostarczono, zegary miały właśnie taki układ wskazówek (10 i 2) – w efekcie Chat nauczył się, że jest to najczęstszy układ wskazówek i nie połączył tego z prawdziwym celem działania zegara.

Temperatura – wskaźnik fantazji AI

Ciekawostka techniczna: modele językowe mają tzw. wskaźnik „temperatury”, który kontroluje, jak bardzo losowe są generowane odpowiedzi. Im wyższa temperatura, tym bardziej kreatywne, ale i bardziej ryzykowne odpowiedzi. Przy niskiej temperaturze odpowiedzi będą ostrożne i przewidywalne, ale przy wysokiej – cóż, AI może zacząć tworzyć własne scenariusze filmowe.

Więc następnym razem, gdy ChatGPT zacznie Ci opowiadać, jak wspaniałym jesteś zdobywcą Oskara, pozwól mu na chwilę tej radości. A potem sprawdź w Google, czy aby na pewno czegoś nie przespałeś.

Czy halucynacje mogą być groźne?

Niestety tak. Chociaż ChatGPT jest na tyle młody, że większość jego wpadek można łatwo wyłapać, to nie każda historia kończy tylko jako anegdota do piwa. We wspomnianym wyżej przypadku prawnym, nierozważni adwokaci stali się tego dnia biedniejsi o 5000 USD kary i na tym się skończyło. Jednak halucynacje np. w modelach medycznych mogłyby mieć znacznie groźniejsze konsekwencje.

I problemem nie jest tu tylko sam model, który nigdy nie ma 100% dokładności (w przypadku modeli medycznych uznaje się zazwyczaj dokładność 97% za granicę dopuszczalności). Problemem jest czynnik ludzki. Jak zwykle. To ludzie zbyt chętnie podpierają się predykcjami modelu i „zapominają”, że model to tylko narzędzie, które może generować błędne wyniki.

Jak radzić sobie z halucynacjami AI?

No właśnie – co robić w sytuacji, kiedy korzystamy z modelu AI (na przykład do pisania postu na temat halucynacji AI i sposobów na radzenie sobie z tym) i nie chcemy dać się złapać na jego halucynacje?

- Po pierwsze, primo – weryfikuj! Zawsze sprawdzaj informacje podawane przez AI w innych źródłach. To oznacza to, że masz pędzić do biblioteki robić „research” za każdym razem, kiedy zadajesz pytanie do ChataGPT.

Wystaczy, że zadając pytanie, poprosisz o dodanie linków i źródeł. Co ważne, kiedy otrzymasz odpowiedź, kliknij w podane linki i sprawdź, czy rzeczywiście zawierają dane, które chat zwrócił w swojej odpowiedzi. - Po drugie, primo – zadawaj precyzyjne pytania. Im bardziej dokładne pytanie zadasz, tym większe prawdopodobieństwa wyszukania prawidłowych informacji.

- Bądź krytyczny – nie ufaj ślepo odpowiedzi chataGPT, tylko dlatego, że 100 wcześniejszych było poprawnych. Pamiętaj, ten sam model potrafi zastosować algorytm propagacji wstecznej z optymalizatorem Adam, a jednocześnie tłumaczyć Ci, że koreański dyktator częstował amerykańskiego prezydenta krakersami.

Warto pamiętać, że modele AI mogą mieć ogromną wiedzę z danego zakresu i popełniać podstawowe błędy z innego zakresu.

Czy AI kiedykolwiek przestanie halucynować?

Prawdopodobnie nigdy całkowicie. AI ciągle się uczy, staje się coraz lepsza, ale błędy i halucynacje będą jej towarzyszyć – choćby jako przypomnienie, że nawet najbardziej zaawansowana technologia jest trochę jak my: nieidealna, ale za to wyjątkowo twórcza.

Warto też zauważyć, że zespoły pracowników odpowiedzialnych za duże modele LLM nie osiadły na laurach, tylko na bieżąco naprawiają wszelkie stwierdzone uchybienia. Twórcy AI pracują nad zmniejszeniem liczby halucynacji poprzez ulepszanie algorytmów i danych treningowych. Jednak całkowite wyeliminowanie tego problemu może być trudne. Dlatego tak ważne jest, aby użytkownicy byli świadomi ograniczeń AI i korzystali z niej z rozwagą.

Podsumowanie

Sztuczna inteligencja to niesamowite narzędzie. Może pomóc, zaskoczyć, rozbawić, a czasem… po prostu gada fikipąsy jak genZ po drugim energolu. I choć coraz rzadziej daje się złapać na kompletne absurdy, to halucynacje wciąż się zdarzają – i będą się zdarzać.

Dlatego kluczowa umiejętność w świecie AI to nie tylko „umieć pytać”, ale też umieć sprawdzać. AI może podać Ci genialne wytłumaczenie zjawiska kwantowego, a zaraz potem wymyślić, że Elon Musk grał drugoplanową rolę w „Titanicu”. I zrobi to bez mrugnięcia kursorem.

Używaj AI z głową. Korzystaj z jej możliwości, ale nie rezygnuj z własnego rozsądku. Bo choć modele językowe też mają swoje „neurony”, Twoje wciąż są w 100% organiczne.